En los últimos años, con el aumento del poder de computo, varias técnicas de las Ciencias de la Computación se han adoptado en distintas áreas de conocimiento. Machine Learning, Big Data y Artificial Intelligence, son algunas herramientas de Data Science que están siendo aplicadas en áreas donde no se se esperaba. Con ello, estar involucrado en Data Science toma mayor relevancia.

En economía, el uso de datos y la inferencia a partir de ellos, es un herramienta que ha sido utilizada por los económetras desde hace varias décadas. Por éstas razones, explorar algunas técnicas de Data Science parece una oportunidad natural para realizar aplicaciones en econometría en la actualidad. El objetivo de este documento es presentar algunas de dichas oportunidades que ofrece el Machine Learning y el Big Data para la Evaluación de Impacto, cuya herramienta principal es la econometría.

El documento esta dividido como sigue:

En la Sección 1 se presenta una introducción a los conceptos de Data Science, Machine Learning y Big Data. En la Sección 2 se habla de forma general sobre la Evaluación de Impacto. En la Sección 3 se exponen algunos ejemplos de aplicaciones de Machine Learning en la Evaluación de Impacto y finalmente en la Sección 4, se comparten algunos enlaces a recursos relacionados con estos temas.

1. Machine Learning y Big data

En la última década escuchar las palabras Aprendizaje automático (Machine learning, o ML en inglés), grandes cantidades de datos (Big data, o BD en inglés), ciencia de datos (Data Science, o DS en inglés), aprendizaje profundo (Deep Learning, o DL en inglés), Inteligencia Artificial (Artificial Intelligence, o AI en inglés), se ha vuelto común en varias ciencias. Esta sección se enfoca en describir algunos de éstos conceptos.

Es complicado definir qué es DS en pocas palabras sin tener que llegar a una discusión incluso filosófica al respecto. En particular, no hay un concenso en la definición de DS. Sin embargo, podemos ganar algo de entendimiento observando la Figura 1.

Figure 1: Ciencia de datos, tomado de https://sitiobigdata.com/2018/08/27/los-tres-nucleos-de-data-science/

Algunos autores definen a la ciencia de datos como la intersección de Matemáticas, Ciencias de la computación y la especialización en un área de conocimiento. Esta definición me parece suficente, pero algunos expertos como Favio Vázquez, consideran que esta abstracción es muy general. Una discusión al respecto se puede encontrar en el siguiente video Fundamentos de Ciencia de Datos.

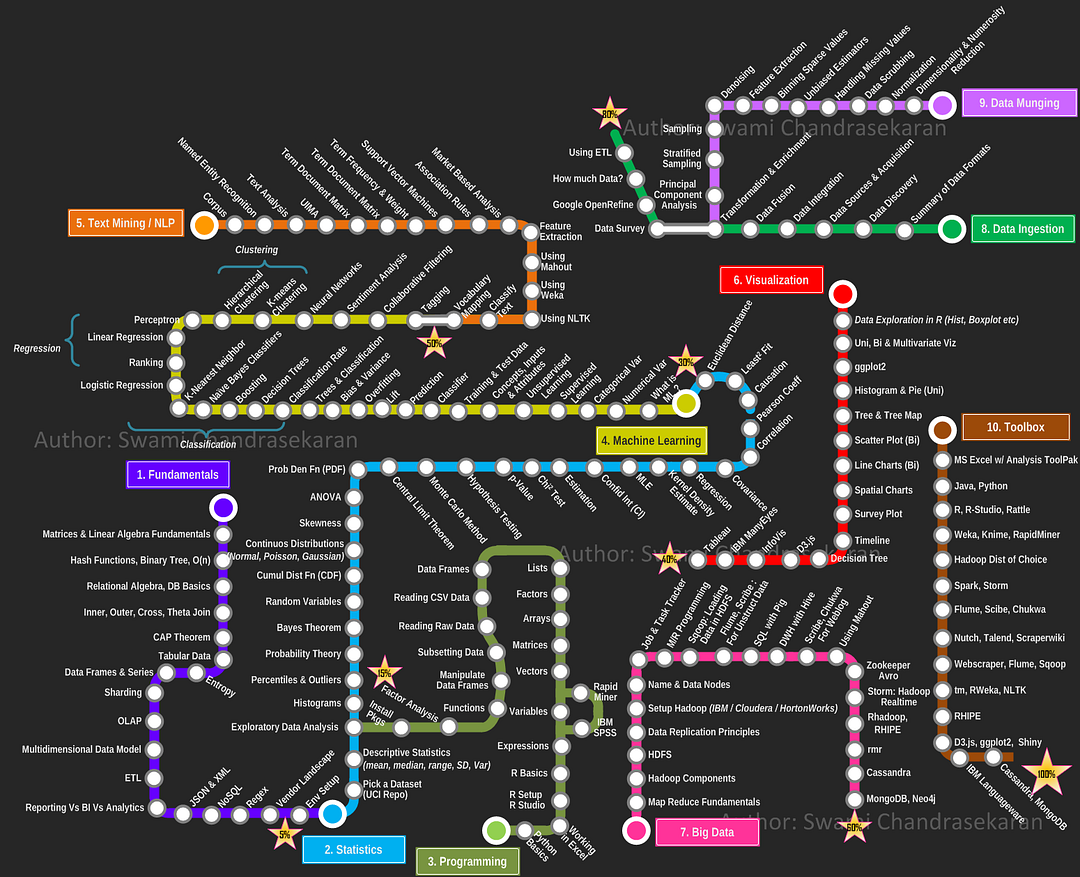

La Figura 2 muestra otra abstracción del concepto de DS, donde se puede observar al BD y otros elementos que componen a la DS.

Figure 2: Ciencia de datos, tomado de https://planetachatbot.com/como-convertirse-data-scientist-e8f61a83d591

La abstración del concepto no es única y varía de autor en autor. Cada una de las definiciones es válida en su contexto.

Bajo cualquier definición de DS, un economista cuya área de especialización sea la econometría aplicada, por ejemplo, dedicado a la Evaluación de Impacto, podría ser considerado un científico de datos; pues en su quehacer profesional combina los elementos que se muestran en la Figura 1. Desde esta perspectiva, hacer uso de las herramientas DS en Evalución de Impacto resulta natural.

De todos los componentes de DS nos enfocaremos en ML y BD. En los siguientes apartados se describen de forma general estos conceptos.

1.1 Machine Learning

En la Figura 1 podemos observar que dentro de lo que se conoce como ML existe todo un mundo por descrubrir.

Figure 3: Principales algoritmos de machine learning, tomado de https://www.sciencedirect.com/science/article/pii/S157401372030071X

Una definición de ML es la siguiente:

El machine learning es un método de análisis de datos que automatiza la construcción de modelos analíticos. Es una rama de la inteligencia artificial basada en la idea de que los sistemas pueden aprender de datos, identificar patrones y tomar decisiones con mínima intervención humana1.

Simplificando bastante esta definición, el ML es un conjunto de algoritmos diseñados para resolver problemas con el uso de datos. Estos problemas se pueden clasificar en tres grandes grupos:

- Aprendizaje supervisado. Un modelo se ajusta conociendo las entradas y las salidas asociadas. El objetivo es hacer predicciones en presencia de incertidumbre. Este tipo de aprendizaje se puede dividir en:

- Clasificación. Predecir respuestas discretas.

- Regresión. Predecir respuestas continuas.

- Aprendizaje no supervisado. Encuentra patrones intrínsecos en datos de entrada que no estan asociados a ninguna salida. Este tipo de aprendizaje se puede dividir en

- Agrupación. Agrupar los datos de acuerdo a sus características intrínsecas.

- Reducción de dimensiones. Reducir el número de características de los datos bajo algún criterio.

- Otros algoritmos de aprendizaje. Destacan los algoritmos de Reinformcement Learning. Este tipo de algoritmos determinan qué acciones debe escoger un agente de software en un entorno dado con el fin de maximizar alguna noción de “recompensa” o premio acumulado.

Al igual que el concepto de DS, las clasificaciones y definición de ML varían de autor en autor.

Hay una gran variedad de algortimos asociados para resolver los diferentes problemas de ML, en scikit se puede encontrar una lista con explicaciones teóricas y ejemplos implementados en Python.

De la gran variedad de algortimos de ML, se describirán de forma general dos algoritmos de aprendizaje supervisado, uno es el algoritmo LASSO y el otro es el algoritmo de árboles de clasificación, algoritmos de regresión y clasificación respectivamente.

El algortimo de regresión LASSO (Least Absolute Shrinkage and Selection Operator) permite encontrar (y así seleccionar) regresores (atributos) para el modelo lineal usual, con un criterio de penalización sobre el número de regresores.

Consideremos el problema de estimar los parámetros del siguiente modelo lineal.

\[\begin{equation} Y_i=\alpha + \beta T_i+ \beta_1 X_i + \varepsilon \end{equation}\]

Entonces, un algoritmo de LASSO resolverá el siguiente problema.

\[\arg \min _{\beta_o} \sum_{i=1}^{N}\left(Y_{i}-\boldsymbol{\beta_o}^{\top} \mathbf{X}_{i}\right)^{2}+\lambda\|\boldsymbol{\beta}_o\|\] este problema puede ser calculado computacionalmente de forma eficiente.

Los árboles de clasificación tienen el objetivo de crear un modelo que prediga el valor de una variable objetivo aprendiendo reglas de decisión simples, inferidas de las características de los datos. Una vez que se ha encontrado la estrutura del árbol, la clasificación se realiza de la siguiente forma:

Los árboles estan compuestos por nodos y hojas. A los nodos llegan datos con diferentes características, y se toma una desición para separarlos. Para ello, se toma una característica \(k\) y un valor umbral \(c\), para dicha característica. Los datos que superen el umbral pasan a la rama izquierda, hasta llegar al siguiente nodo. Los datos que no superen dicho umbral pasan a la rama derecha, hasta llegar al siguiente nodo. El proceso continúa, hasta que se llega a una hoja (nodo donde no se hace decisión), esta hoja es la clasificación asignada a los datos que llegan ahí.

Para utilizar el árbol de clasificación se deben tener los valores de \(k\) y \(c\) para cada nodo. La idea de como se calculan dichos valores es la siguiente:

- En cada nodo llegan \(N\) datos, que se se quieren clasificar en \(N_l\) y \(N_r\)

- Se elige la característica \(k\) y el valor límite \(c\) con lo que definimos \(\theta = (k,c)\)

- Se calculan los errores al cuadrado, respecto a la media, para cada rama y se suman para formar una función \(Q(k,c)\)

- Se encuentra \(\theta\) de tal forma que se minimice \(Q(k,c)\)

- Lo anterior se repite hasta que se logra una cantidad de datos deseada (en el nodo que fungirá como hoja) o cuando se llega a una profundidad deseada (número de desiciones tomadas).

La Figura 4 muestra un árbol de clasificación para los datos iris2, el algoritmo de aprendizaje se configuró para deternerse con una profundidad dos. Es decir, hay dos nodos de decisión, donde en cada nodo se pregunta si su caraterística asignada está o no dentro del umbral correspondiente. Se observan tres hojas, que corresponden con los tres tipos de datos.

Figure 4: Árbol de clasificación, tomado de https://www.iartificial.net/arboles-de-decision-con-ejemplos-en-python/

Mencionaremos nuevamente estos algoritmos en la Sección 3. Como último punto de esta sección se presenta el concepto de BD.

1.2 Big Data

A grandes razgos, el BD se refiere a la integración, gestion y analisis de grandes cantidades de datos.

Para definir qué es una gran cantidad de datos podría tomarse como umbral el momento en el que el software usual no pueda gestionar los datos (podrían ser terabytes o petabytes). Para la gestión de BD existe software especializado que resuelve este problema. Por otro lado, la gran cantidad de datos presenta características que en un principio se conocían como las tres V del BD, veáse la Figura 5.

Figure 5: Big data y 3V , tomado de Vijayaraj et al. (2016)

Recientemente, algunos autores consideran que las características que deben cumplir los datos para ser considerados BD han aumentado a seis (seis V).

- Volumen. Gran volumen de datos (terabytes y/o petabytes).

- Velocidad. La velocidad con que se reciben y tratan los datos.

- Variedad. Los tipos de datos.

- Veracidad. Sobre la veracidad de los datos.

- Valor. Que los datos sean importantes.

- Variabilidad. Utilizar los datos con distintos fines.

Cabe señalar que las tres últimas V se refieren a características que pueden obtenerse después de un análisis de los datos. En la Figura 5 se muestra la descripción de 5 herramientas de software para BD, se pueden obsevar algunas de las organizaciones en donde están implementadas, el lenguaje de programación que utilizan, además de una descripción de las tres primeras V.

Es importante indicar que se pueden desarrollar los algoritmos de ML con o sin BD. Para tener una idea de cómo utilizar un software para trabajar con BD en R, se puede consultar el siguiente video Introducción al mundo de Spark en R.

En la Sección 3 se exploran las oportunidades que ofrece el ML y BD a los económetras aplicados en Evaluación de impacto, pero, ¿qué es la evalución de impacto? A continuación se presenta una introducción a dicho tema.

2. Evaluación de impacto

La experiencia nos dice que el hecho de someterse a diferentes circustancias en determinado momento llevará en un periodo futuro \(t\) a diferentes situaciones. Esta intuición ha sido retratada en varios filmes cinematográficos como: El efecto mariposa, El teléfono, entre otros, en donde un cambio en la toma de decisiones, llevará a las personas a situaciones distintas. Otro lugar donde esto ocurre es en algunos problemas de matemáticas, donde pequeños cambios en las condiciones iniciales afectan las trayectorias de un sistema dinámico Deterministic Nonperiodic Flow; en general, pequeños cambios en un sistema pueden resultar en grandes diferencias en el comportamiento de este, como en la Teoría del caos.

Estas situaciones no solo se presentan en filmes cinematográficos o en teoría matemática de sistemas, también se encuentran en las ciencias sociales. El hecho de ser beneficiado o no por un programa público o privado (recibir transferecnias monetarias estatales, becas de estudio, acceso gratuito a servicios de salud, acceder a créditos bancarios, etc.), tener un cierto color de piel, determinado género, vivir en una ciudad donde las leyes apoyan a la despenalización del aborto, estudiar en una institución de élite, vivir en una ciudad que experimenta un cambio en el salario mínimo, estar sometido a campañas publicitarias, y un largo etc., son circunstancias que al presentarse pueden tener repercusiones de distintos tipos sobre los individuos que las experimenten.

La evaluación de impacto (EI)3 trata de cuantificar que porción del cambio en una variable de interés es causado por la recepción de una intervención, o por estar expuesto a un Tramiento. Por ejemplo, puede ser de interés el conocer si ser beneficiado con transferencias monetarias mejorará los ingresos económicos para generaciones futuras (Parker and Vogl 2018).

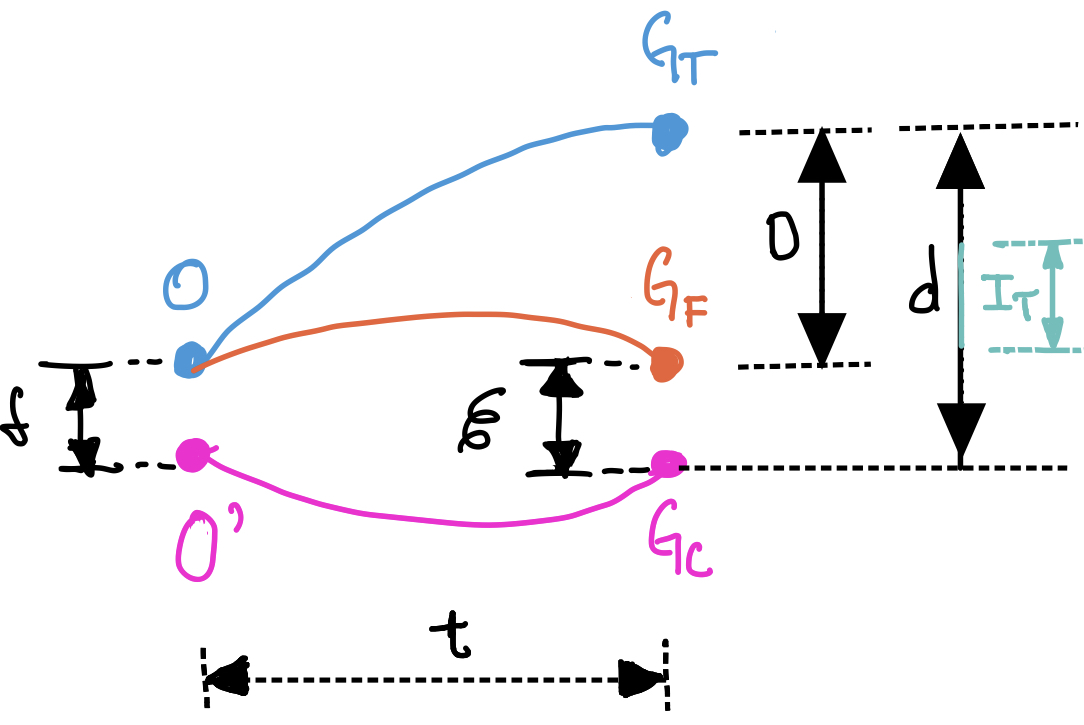

Para ejemplificar el problema de la EI (veáse la Figura 6), supongamos que tenemos un grupo que se encuentra en una situación \(O\), y este grupo se somete a un tratamiento \(T\). Así, al someter a tratamiento al grupo (será el grupo de tratamiento). Al transcurrir el tiempo \(t\), este grupo se encontrará en la situación \(G_T\). En caso de no haberse sometido, sabemos que este grupo estaría en una situación \(G_F\). Por tanto, el efecto del tratamiento está dado por la diferencia en la variable de interés de estas dos situaciones, en este caso ejemplificada por la cantidad \(D\).

Figure 6: Evaluación, elaboración propia

Una vez que se adopta el tratamiento, no se puede observar la situación \(G_F\) y así determinar \(D\) es imposible. Entonces llamaremos a \(G_F\) la situación contrafactual, situación que no ha sucedido en el contexto actualmente observable, pero que podría haber ocurrido (en el caso de no adoptar el tratamiento). Lo ideal sería tener dos grupos indenticos y que un grupo adoptara el tratamiento y otro no, y con ello poder cuantificar \(D\), pero sabemos que esto es imposible, pues la situación de cada individuo es distinta. Aquí comienzan los problemas de la EI, y se abre la posibilidad de ingeniosas y brillantes soluciones.

La idea general para cuantificar el impacto es tener un grupo que se encuentre “casi” bajo la misma situación inicial del grupo de tratamiento, digamos en \(O'\), y específicamente a este grupo no someterlo al tratamiento (grupo de control). La diferencia inicial entre estos dos grupos (tratamiento y control) está representada por \(\delta\). Como se desea que los grupos sean “muy parecidos”, entonces se quiere que \(\delta\rightarrow 0\). El grupo de control será un intento de emular al grupo contrafactual. El grupo contrafactual es el grupo que estaría en la situación no observada \(G_F\) una vez transcurrido \(t\).

Al transcurrir \(t\), el grupo de control estará en la situción \(G_C\), lo ideal sería que \(G_F=G_C\), para así determinar a \(D\), pero eso es imposible. La diferencia que existe entre la situación \(G_F\) y \(G_C\), se denota por \(\varepsilon\). Se esperá lograr que la situación \(G_C\) sea tan parecida a la situación \(G_F\) como sea posible, es decir, lo que se espera tener es \(\varepsilon\rightarrow 0\).

Como solución para cuantificar el impacto, se puede intentar medir la diferencia de la de la variable de interés entre las situaciones \(G_T\) y \(G_C\) (ejemplificada por \(d\)). El problema con esto es que \(D\neq d\), primero por construcción y además podría suceder que \(d\) este influenciada por situaciones externas al tratamiento. Considerando estas circustancias, se intenta recuperar la mayor parte de \(D\) a través de \(d\) y a esta medición la llamaremos el impacto del tratamiento \(I_T\).

Los problemas para la EI son diversos, debido a todas las circunstancias que los determinan. Por ejemplo: ¿cómo asignar a los grupos de control y tratamiento, de tal forma que \(O\) y \(O'\) sean muy parecidos?, ¿cómo construir \(G_C\), en caso de que no sea posible tener de forma directa la información del grupo de control?, ¿cómo definir y medir \(I_T\)?, etc.

Para ello, se ha recurrido a utilizar distintas técnicas: asignación aleatoria, variables instrumentales, regresión multivariada, Diferencias en diferencias, matching, regresión discontinua, control sintético, etc. Estos tópicos caen dentro de la econometría, la aplicación precisa y criterios de implementación de estas técnicas están fuera de los fines de este blog, los detalles de estos tópicos se pueden consular en (Cameron and Trivedi 2005) y (Angrist and Pischke 2008). Los avances en el uso de éstas y otras técnicas para la evaluación de impacto no se detienen. Si se desea revisar literatura de avances recientes, se puede consultar Literature on Recent Advances in Applied Micro Methods.

Dentro de la búsqueda por nuevas y mejores soluciones para resolver problemas de EI, en los últimos años se han implementado esfuerzos por hacer uso de las ventajas que pueden ofrecer métodos asociados a machine learning y big data (Athey and Imbens 2019), para constestar preguntas relacionadas a inferencia causal, y con ello dar solución a los problemas de EI. En la próxima sección abordamos algunos ejemplos al respecto.

3. Machine learning y big data como herramientas para la evaluación de impacto

La forma de insertar ténicas de una área a otra parece subjetiva, es decir, decidir si un algoritmo es propio del ML tiene que ver con la secuencia de cómo se aprendan éstos. Por ejemplo, en el libro The Elements of Statistical Learning Data Mining, Inference, and Prediction (ESoSL), que es considerado un referente para aprender ML, en el capítulo 3: Linear Methods for Regression, se aborda el problema de mínimos cuadrados ordinarios (MCO) de forma similar a como se puede encontrar en libros clásicos de econometría. Lo interesante es que MCO se utiliza para EI, de la siguiente forma4

\[\begin{equation} Y_i=\alpha + \beta T_i+ \beta_1 X_i + \varepsilon \tag{1} \end{equation}\]

\(Y_i\) representa la medición de interés para EI, \(T_i\) toma el valor \(1\) en el caso que las mediciones sean de un individuo del grupo de tratamiento y \(0\) si se trata de un individuo en el grupo de control, \(X_i\) son todos aquellos datos externos a \(T_i\) con los que se cuente y que servirán para identificar el efecto causal de \(T\) sobre \(Y\). Así, mediante MCO se estima el valor de \(\beta\) y este representará el efecto de \(T\) sobre \(Y\)5.

Entonces, si primero se revisó ESoSL y después un texto de EI, la conclusión es que EI hace uso de ML6. Aquí el detalle está en que hablaremos de la inserción del ML en EI cuando se utilicen algoritmos de ML que no se consideran usualmente para resolver problemas de EI.

La forma en cómo se utilizan algoritmos de machine learning y técnicas de BD en la evaluación de impacto es bastante técnica, pero abordaremos algunos ejemplos más adelante. Un enunciado simplista para sintetizar el uso de estos métodos en EI, pero que da una perspectiva del objetivo de esta sección, es el siguiente

Para utilizar ML y BD en EI es necesario describir el problema de EI como un problema matemático cuya solución pueda implementarse como un algoritmo de ML y/o uso de técnicas de BD. Lo cuál no es necesariamente fácil de construir7.

Más allá de solo querer aplicar algoritmos de ML (por el gusto) a problemas EI, se busca obtener mejores conclusiones, o complementar las conclusiones realizadas con técnicas usuales de EI. Por ejempo, al tomar la estructura (1) para EI, se puede utilizar LASSO (de la Sección 1) en lugar de MCO. En general, \(\beta\) será distinto y EI tendrá otras conclusiones, que pueden servir para reformular la estructura para la EI o para confirmar las conclusiones iniciales.8

Un ejemplo para cuestionar las conclusiones que se pueden obtener en la EI utilizando técnicas usuales se encuentra en Varian (2014), donde se hace referencia a un artículo publicado en \(1996\). En este artículo se examina si la raza juega un papel significativo en la aprobación de una hipoteca.

Al resolver el problema con una técnica econométrica usual, se concluyó que el coeficiente asociado a la raza (en este caso el tratamiento sería pertenecer o no a una determinada raza) era estadísticamente significativo, con un impacto negativo en la probabilidad de obtener una hipoteca si los aplicantes eran afroamericanos.

Al aplicar árboles condicionales (una variante de árboles de clasificación, de la Sección 1) se obtiene que, para decidir si se rechazaba o se aceptaba la hipoteteca, la raza es una variable poco importante.

Posteriormente, a un nuevo conjunto de datos se le aplicó tanto el modelo econométrico usual como los árboles condicionales. Lo interesante es que las conclusiones con ambos modelos sobre la aprobación de la hipoteca fueron casi iguales para estos nuevos datos. Entonces, ¿la variable de raza es o no imporante para la aprobación de la hipoteca?

En este ejemplo se observa que el uso de una técnica de ML revela consideraciones que con estudios usuales de EI toman una importancia distinta. Pues, se podría concluir que hay discriminación en la aprobación de una hipoteca, cuando posiblemente no sea el caso.

Otro ejemplo, que se encuentra en Varian (2014), es utilizar ML para evaluar el efecto de una campaña de publicidad en internet. Para ello, se puede estimar la serie de tiempo de la variable de interés (visitas a una página web, compras online realizadas, etc.) como función de su historia pasada, efectos de temporada, productos disponibles, búsquedas en Google relativas a la variable estudiada, etc. Por la gran cantidad de predictores disponibles, se puede realizar una selección de regresores, por ejemplo, utilizar BSTS (Bayesian Structural Time Series, una técnica considerada de ML).

Posteriormente, se lleva a cabo la campaña publicitaria durante algunos periodos y se registra la variable de intéres. Utilizando el modelo desarrollado previamente, se realiza una predicción de cuál habría sido la salida (en los periodos correspondentes) en ausencia de la campaña publicitaria. La comparación de la salida real con la salida contrafáctica (artificialmente construida) nos da una estimación del efecto causal de la campaña de publicidad en internet sobre la variable de interés.

En los ejemplos anteriores, la aplicación de ML para EI revela una interacción entre el ML y la econometría. En palabras de Yong Tan (Zheng et al., n.d.)

“… si indagamos más profundamente en los dos enfoques, se puede comprender que probablemente existen las mismas ideas filosóficas que describen con precisión el proceso de generación de datos. Obviamente, una vez que conocemos la forma en que se generan los datos, podemos obtener más ideas sobre la relación causal en este proceso. Por otra parte, si podemos llegar a saber cómo se generan los datos y de dónde provienen, podemos lograr una mayor precisión predictiva. Por lo tanto, ese es mi punto de vista sobre la integración del aprendizaje automático y la econometría.”

Entonces, parece que la implementación de ML a EI es natural, pero como veremos posteriormente, no es tan sencillo adaptar las herramientas de ML a EI9. La complejidad de la aplicación de ML a EI surge cuando se tiene un contexto de inferencia causal complicado, pues los problemas de ML usualmente están centrados en la resolución predictiva, mientras que las técnicas econométricas utilizadas en la EI están enfocadas en la inferencia causal. Una visión al respecto la ofrece Paulo Goes (Zheng et al., n.d.)

“… la predicción del aprendizaje automático no tiene nada que ver con la inferencia causal, que es el punto clave que debes tener en cuenta. Encontrar un buen modelo de predicción con alta precisión de aprendizaje automático es diferente a inferir la verdadera estructura subyacente de la econometría. Además, el poder predictivo es diferente del poder explicativo. Son dos ángulos muy diferentes.”

Las memorias del panel Zheng et al. (n.d.) son muy interesantes y se intersectan con ideas presentadas en Athey and Imbens (2019). En las memorias se habla de la interacción \(ML\rightarrow Econometría\), \(ML\leftarrow Econometría\) y \(ML\leftrightarrow Econometría\) y de cómo cada área puede fortalecer a la otra.

Regresando al tema de este blog, especifícamente \(ML\rightarrow EI\). No es tan sencillo proponer un esquema de ML para EI mediante la obtención de \(I_T\), pero en el trabajo de Athey and Imbens (2019) se resumen algunas investigaciones al respecto, retomo algunas de ellas.

Una forma de medir \(I_T\) es definiendo el efecto promedio en los tratados ATE (Average Treatment Effect), que se interpreta como la ganancia hipotética debida al tratamieto para un individuo seleccionado al azar. La expresión para el ATE es la siguiente

\[\tau=\mathbb{E}\left[Y_{i}(1)-Y_{i}(0)\right]\]

Donde \(Y_i(w)\) es el resultado potencial (\(G_T\) cuando \(w=1\) o \(G_F\) cuando \(w=0\)) de la unidad \(i\). Como se comentó en el Sección 2, \(Y_i(0)\) es no observable. Por tal motivo, se tienen algunas expresiones equivalentes para hacer la estimación de \(\tau\), una de ellas es

\[\tau = \mathbb{E}\left[\mu\left(1, \mathbf{X}_{i}\right)-\mu\left(0, \mathbf{X}_{i}\right)\right] \]

Donde \(\mu(W_i,X_i)\) es la esperanza codicional de la salida, \(W_i\) es el tratamiento binario, \(X_i\) es el vector de covariables (todos los datos disponibles independientes al tratamiento)10.

La técnica de ML conocida como Covariate balancing arroja buenos resultados en la estimación de \(\mu\). Este algoritmo ha sido implementado por Susan Athey.

El Covariate balancing es un proceso que optimiza los pesos de las observaciones, para llevar a los mismos valores medios al grupo de tratamiento y control. Este enfoque permite una estimación eficiente.

También se puede utilizar ML para descubrir la heterogeneidad del efectos del tratamiento (treatment effect heterogeneity). Con esto se pueden resolver las preguntas ¿qué personas se benefician más de un tratamiento?, ¿para qué personas es positivo el efecto del tratamiento?, ¿cómo cambian los efectos del tratamiento con las covariables?

Para medir la heterogeneidad se define el ATE condicional (CATE), como

\[\tau(x)=E\left[\tau_{i} \mid \mathbf{X}_{i}=x\right]\]

Donde \(\tau_{i}=Y_{i}(1)-Y_{i}(0)\) es el efecto del tratamiento para el individuo \(i\). Recordemos que el problema principal es que no podemos observar \(\tau_i\), por esto se proponen diferentes esquemas de estimación, para los cuales se pueden aplicar las siguientes técnicas de ML: meta-learners, BART (Bayesian additive regression trees), R-leaner, redes neuronales. La explicación de estas técnicas no es el objetivo principal del blog, pero se mencionan para los lectores interesados.

Se puede utilizar ML para el diseño experimental, por ejemplo, para la asignación a grupos de tratamiento y control, algunos de los algortimos para ello son: Thompson sampling (Multi-armed bandit), UCBs (Upper Confidence Bounds), en particular estas técnicas de ML se clasifican como Reinformcement Learning.

Las técnicas ML en EI, se pueden extender a datos panel. Supóngase que se tienen \(Y_{it}\) observaciones de \(N\) unidades sobre \(T\) periodos de tiempo y un tratamiento binario \(W_{it}\)

\[\mathbf{Y}=\left(\begin{array}{ccccc} Y_{11} & Y_{12} & Y_{13} & \ldots & Y_{1 T} \\ Y_{21} & Y_{22} & Y_{23} & \ldots & Y_{2 T} \\ Y_{31} & Y_{32} & Y_{33} & \ldots & Y_{3 T} \\ \vdots & \vdots & \vdots & \ddots & \vdots \\ Y_{N 1} & Y_{N 2} & Y_{N 3} & \ldots & Y_{N T} \end{array}\right) \quad \mathbf{W}=\left(\begin{array}{ccccc} 1 & 1 & 0 & \ldots & 1 \\ 0 & 0 & 1 & \ldots & 0 \\ 1 & 0 & 1 & \ldots & 0 \\ \vdots & \vdots & \vdots & \ddots & \vdots \\ 1 & 0 & 1 & \ldots & 0 \end{array}\right)\]

El problema de estimar los ATEs se puede transformar en un problema de completar matrices.

\[\mathbf{Y}(0)=\left(\begin{array}{ccccc} ? & ? & Y_{13} & \ldots & ? \\ Y_{21} & Y_{22} & ? & \ldots & Y_{2 T} \\ ? & Y_{32} & ? & \ldots & Y_{3 T} \\ \vdots & \vdots & \vdots & \ddots & \vdots \\ ? & Y_{N 2} & ? & \ldots & Y_{N T} \end{array}\right)\text{(salida del grupo de control )}\]

\[\mathbf{Y}(1)=\left(\begin{array}{ccccc} Y_{11} & Y_{12} & ? & \ldots & Y_{1 T} \\ ? & ? & Y_{23} & \ldots & ? \\ Y_{31} & ? & Y_{33} & \ldots & ? \\ \vdots & \vdots & \vdots & \ddots & \vdots \\ Y_{N 1} & ? & Y_{N 3} & \ldots & ? \end{array}\right)\text{(salida del grupo de tratamiento )}\]

Por tanto, el problema de estimar los efectos causales se convierte en el de imputar los valores faltantes en una matriz, el cual se puede resolver con un algoritmo de ML conocido como Matrix completion problem.

Estos esquemas no son los únicos, pero se pretende ilustrar el uso de los algoritmos de ML, al menos como idea, en la EI. Cabe destacar que todo lo descrito puede llevarse acabo con el manejo de grandes cantidades de datos, si bien la literatura no ahonda en esta situación, se entiende que es posible.

La información y técnicas relacionadas a temas de ML, EI y el uso de ML en EI, comienza a ser extensa. En la Sección 4 se pueden encontrar enlaces a recursos para conocer más sobre estos temas.

Para concluir, se puede decir que la principal barrera que se ha encontrado en promover las técnicas de ML en problemas de EI radica en la diferencia de enfoques. En EI se tiene la necesidad de justificar con modelos econométricos la inferencia causal, mientras que en ML se da prioridad a los resultados computacionales enfocados en la estimación; discusiones al respecto se pueden encontrar en (Zheng et al., n.d.) y (Athey and Imbens 2019). Los próximos años proyectan una producción científica abundante en estos temas y una posible cooperación \(ML\leftrightarrow Econometría\), y no necesariamente solo en aplicaciones de EI.

4. Algunas herramientas para profundizar

Para aprender sobre los distintos temas abordados en este blog existen bastantes recursos en línea.

La implementación de los algoritmos se puede realizar con diferentes herramientas

- Hands-On Machine Learning with R

- Biblioteca mlr3 en R

- Biblioteca caret en R

- scikit en Python

- PyTorch

también se pueden implementar en WOLFRAM, MATLAB, Julia, entre otros.

Para Evaluación de Impacto

MicroMasters Program in Data, Economics, and Development Policy micromaster del MIT con los profesores Esther Duflo y Abhijit Banerjee

Abdul Latif Jameel Poverty Action Lab Executive Training: Evaluating Social Programs 2011

Impact Evaluation Methods with Applications in Low- and Middle-Income Countries

Para temas de ML y EI

Angrist, Joshua D., and Jörn-Steffen Pischke. 2008. Mostly Harmless Econometrics: An Empiricist’s Companion. 1st ed. United Kingdom: PRINCETON UNIVERSITY PRESS.

Athey, Susan, and Guido W. Imbens. 2019. “Machine Learning Methods That Economists Should Know About.” Annual Review of Economics 11 (1): 685–725. https://doi.org/10.1146/annurev-economics-080217-053433.

Cameron, A. Colin, and Pravin K. Trivedi. 2005. Microeconometrics: Methods and Applications. 1st ed. New York, USA: CAMBRIDGE UNIVERSITY PRESS.

Parker, Susan W, and Tom Vogl. 2018. “Do Conditional Cash Transfers Improve Economic Outcomes in the Next Generation? Evidence from Mexico.” Working Paper 24303. Working Paper Series. National Bureau of Economic Research. https://doi.org/10.3386/w24303.

Varian, Hal R. 2014. “Big Data: New Tricks for Econometrics.” Journal of Economic Perspectives 28 (2): 3–28. https://doi.org/10.1257/jep.28.2.3.

Vijayaraj, J., R. Saravanan, P. Victer Paul, and R. Raju. 2016. “A Comprehensive Survey on Big Data Analytics Tools.” 2016 Online International Conference on Green Engineering and Technologies (IC-GET), 1–6.

Zheng, Eric, Yong Tan, Paulo Goes, Ramnath Chellappa, D.J. Wu, Michael Shaw, Olivia Sheng, and Alok Gupta. n.d. “When Econometrics Meets Machine Learning.” Data and Information Management 1 (2). Berlin: Sciendo: 75–83. https://doi.org/https://doi.org/10.1515/dim-2017-0012.

https://www.sas.com/es_mx/insights/analytics/machine-learning.html↩

La base de datos contiene \(150\) registros con \(4\) mediciones realizadas a 3 tipos de flores, también se cuenta con el tipo de flor de la cual proviene cada registro.↩

El siguiente curso ofrece una descripción detallada del tema Evaluación de impacto de programas sociales↩

existen formas más sofisticadas, pero no son de interés por el momento↩

para que esto sea cierto se tienen que suponer algunas condiciones matemáticas↩

el método de MCO es el ejemplo elegido, pero esto tambien sucede con regresión logistica, bootstraps, entre otros↩

punto de vista del autor↩

De forma similar a MCO, se tienen propiedades asintóticas del estimador LASSO, esto puede consultarse en https://projecteuclid.org/download/pdfview_1/euclid.ejs/1389795619↩

recordemos que algunos de los objetivos son mejorar o completar conclusiones, podría agregarse el poder de cómputo que ofrece el ML↩

en cualquier esquema de estimación del ATE se necesitan algunas hipótesis, como inconfundibilidad, pero no se profundizará en este aspecto↩